Funkcja wiarygodności

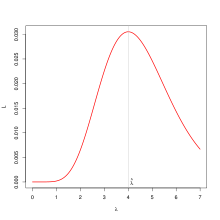

Funkcja wiarygodności (wiarygodność) – w statystyce, funkcja parametru modelu i próby losowej, która jest proporcjonalna do prawdopodobieństwa zaobserwowania próby o konkretnej postaci przy różnych parametrach modelu. Wyraża „wiarygodność” wartości parametru w obliczu danych. Odgrywa kluczową rolę we wnioskowaniu statystycznym[1]. Jej nazwę wprowadził Ronald Fisher w 1922[2].

Definicja[edytuj | edytuj kod]

Najbardziej ogólna postać funkcji wiarygodności zapisywanej także jako lub z użyciem symbolu to[1]:

gdzie to arbitralna dodatnia stała proporcjonalności wynikająca ze specyficzności przyjętego modelu, to reprezentujący różne hipotezy wektor zmiennych wartości parametru a to stały, dany wektor obserwacji. to funkcja gęstości lub masy prawdopodobieństwa, dla przyjętego modelu statystycznego[1][3].

Realizacja funkcji wiarygodności dla wektora obserwacji ma z reguły dla danych iid formę typu[4]:

Wiarygodność to, w uproszczeniu, prawdopodobieństwo parametru w konkretnym kontekście ustalonych obserwacji i modelu. Ma podobną postać do prawdopodobieństwa danych dla parametru (czyli funkcji gęstości lub masy), ale przyjmuje odwrotnie to, który czynnik jest losowy, a który stały[1][2].

Interpretacja[edytuj | edytuj kod]

Interpretacja wiarygodności ma sens tylko z zachowaniem kontekstu; bardziej przyjaznym wskaźnikiem jest iloraz wiarygodności, który wskutek dzielenia pozbawiony jest stałej reprezentującej specyfikę modelu[1].

Oszacowanie wiarygodności nie jest jednak samo w sobie wyczerpującą podstawą do osądzania prawdziwości hipotez. Sam fakt, że jedno wyjaśnienie jest dużo bardziej prawdopodobne od alternatywnego, w oderwaniu od dodatkowych wskaźników i rozumowania, nie jest wyczerpująco diagnostyczny. Ilustruje to problem błędu rozumowania prokuratorskiego, takiego jak sprawa Sally Clark, matki dwójki dzieci, które zmarły z rozpoznaniem nagłej śmierci łóżeczkowej. Po śmierci drugiego dziecka została oskarżona o morderstwo i skazana w 1999, w dużej mierze w oparciu o zeznania profesora pediatrii, który oszacował szansę na dwukrotne wystąpienie bardzo rzadkiej w populacji przyczyny śmierci przypadkiem na bardzo małą. Proces ściągnął na Clark dużą antypatię opinii publicznej. Została uniewinniona na podstawie nowo ujawnionych dowodów w 2003, popadła jednak w alkoholizm i zmarła w 2007 w wieku 43 lat, osieracając jedno żyjące dziecko. Sposób argumentacji statystycznej przedstawionej w trakcie procesu był potem głęboko krytykowany jako tragiczne nadużycie[5][6].

Prawo wiarygodności[edytuj | edytuj kod]

Pojęcie wiarygodności może być pomocne we wnioskowaniu w przypadku porównywania dwóch hipotez. Zgodnie z prawem wiarygodności, jeżeli obie są zgodne z dostępnymi danymi, większe poparcie w danych ma hipoteza o większej wiarygodności[7]. Porównując wiarygodności można nie tylko wskazać, która z hipotez ma lepsze poparcie, ale możliwe jest również mierzenie tego poparcia dzięki ilorazowi wiarygodności[8].

Zastosowania[edytuj | edytuj kod]

Wiarygodność jest wykorzystywana we wszystkich głównych podejściach do wnioskowania statystycznego (np. częstościowym czy bayesowskim). Część statystyków preferuje odrębne podejście oparte wręcz wyłącznie na ilorazach wiarygodności[1].

Ponieważ wiarygodność jest z reguły używana w postaci ilorazów, często wyraża się ją w postaci logarytmu naturalnego. Jest on także łatwiejszy w maksymalizacji, co wykorzystuje metoda największej wiarygodności w estymacji[1].

Iloraz wiarygodności[edytuj | edytuj kod]

Iloraz wiarygodności, zapisywany z reguły przy pomocy symbolu to:

Wiele testów statystycznych opiera się o – poprzedzone wyborem odpowiedniego (lub nie) modelu, definiującego – porównanie wiarygodności dwóch hipotez. Takie porównanie jest częścią lematu Neymana-Pearsona, i było ważnym historycznym źródłem kształtującym testy w podejściu częstościowym. W statystyce bayesowskiej miary tego typu noszą nazwę czynnika Bayesa[1].

Przypisy[edytuj | edytuj kod]

- ↑ a b c d e f g h Alexander Etz, Introduction to the Concept of Likelihood and Its Applications, „Advances in Methods and Practices in Psychological Science”, 1 (1), 2018, s. 60–69, DOI: 10.1177/2515245917744314, ISSN 2515-2459 [dostęp 2019-04-01] (ang.).

- ↑ a b R.A. Fisher, Inverse Probability, „Mathematical Proceedings of the Cambridge Philosophical Society”, 26 (04), 1930, s. 528, DOI: 10.1017/S0305004100016297, ISSN 0305-0041 [dostęp 2019-04-01] (ang.).

- ↑ Patrick Billingsley, Probability and measure, wyd. 3rd ed, New York: Wiley, 1995, s. 422–423, ISBN 0-471-00710-2, OCLC 30735805 [dostęp 2019-04-01].

- ↑ Christopher Stover, Log-Likelihood Function, [w:] MathWorld, Wolfram Research [dostęp 2019-04-01] (ang.).

- ↑ Norman Fenton, Improve statistics in court: Science and law, „Nature”, 479 (7371), 2011, s. 36–37, DOI: 10.1038/479036a, ISSN 0028-0836 [dostęp 2019-04-01] (ang.).

- ↑ Sally Clark, „The Telegraph”, 19 marca 2007, ISSN 0307-1235 [dostęp 2019-04-01] (ang.).

- ↑ 3. Support, 3.3 The Likelihood Axiom, [w:] A.W.F. Edwards, Likelihood. Expanded edition, Baltimore, Londyn: The Johns Hopkins University Press, 1992, s. 30, ISBN 0-8018-4445-2.

- ↑ Elliott Sober, Absence of evidence and evidence of absence: evidential transitivity in connection with fossils, fishing, fine-tuning, and firing squads, „Philosophical Studies”, 143, 2009, s. 63-90, DOI: 10.1007/s11098-008-9315-0.